A Importância da Informação na Estruturação Inteligente do Universo

(Em comemoração aos 200 anos do nascimento de Allan Kardec e 12º aniversário do GEAE)

1. Introdução

Quando falamos em materialismo, sempre nos lembramos das ideias que somente reconhecem a matéria como a única base essencial de constituição do universo. Tal como apreendemos com nossos sentidos, a matéria é algo bem delimitado no espaço e no tempo, algo que podemos sentir, apalpar, carregar, que impressiona nossos sentidos. Hoje, contudo, mesmo os materialistas mais ferrenhos são obrigados a aceitar que essa noção de matéria está longe de ser o constituinte exclusivo do Universo. A física demonstrou a importância de outros ingredientes dentre os quais destacamos a energia. Mas a energia é apenas uma forma diferente (dentro das teorias da física) de se caracterizar a matéria. Pode-se encontrar facilmente o equivalente "energético" de qualquer quantidade de matéria (definida por uma massa, densidade etc). Nesse texto, chamamos a atenção para um tipo de ingrediente que apenas recentemente (nos últimos 60 anos) foi reconhecido como de importância fundamental na estruturação do mundo: a informação. Mas a informação é algo imaterial, portanto, já estamos longe das antigas proposições materialistas de que o Universo é constituído apenas do que podemos ver, ou ainda, daquilo que a ciência poderia medir através de seus aparelhos.

Esse reconhecimento é um passo importante na direção da aceitação do ingrediente espiritual como o terceiro grande constituinte do universo. Aventuramo-nos aqui em imaginar que a informação é um importante parâmetro capaz de distinguir univocamente o grau de "vivificação" da matéria, isto é, quanto distante do estado "inanimado" ela se encontra. Um problema recente é a questão se é possível haver criação de informação a partir de sistemas puramente físicos (isto é, inanimados). Uma eventual resposta a essa indagação pode nos levar bem longe de onde estamos conceitualmente.

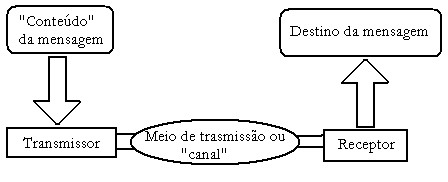

Antes, porém, de iniciar essa aventura, devemos examinar um pouco mais detalhadamente o significado do conceito de informação e de como ela se transmite de um sistema a outro. Os ingrediente básicos de um sistema de comunicação completamente geral podem ser representados como mostra a figura abaixo:

O conteúdo da mensagem é algo imaterial que existe em princípio, na mente (Espírito). O transmissor é a unidade responsável pela transmissão da mensagem. Ela faz isso "codificando", isto é, escrevendo sob uma convenção pré estabelecida que pode ser lida por outros sistemas semelhantes. O meio ou canal de transmissão é o "medium" no sentido comum, isto é, o subsistema responsável por transmitir aquilo em que foi codificada a mensagem. O "Receptor" é uma unidade capaz de decodificar a mensagem e transformá-la em algo compreensível pelo "destino da mensagem". Esse modelo aplica-se a uma vasta quantidade de sistemas materiais como telefones (celulares ou fixos), transmissão de dados pela internet, comunicação falada etc. No caso de duas pessoas conversando o "meio" é o ar pois os sinais imateriais são transformados em ondas de pressão que emanam do transmissor e se propagam livremente pelo ar. No caso de comunicações feitas com sinais luminosos (p. ex. transmissão de sinais marítimos) o meio é a própria luz.

Lembramos que esse modelo também aplica-se às comunicações mediúnicas. Nele identificamos o conteúdo da mensagem e seu impacto no destino como idéias impressas na mente dos Espíritos que enviam e dos que recebem as mensagens. O transmissor/receptor são os Espíritos envolvidos na comunicação, enquanto que o "meio" é o médium que serve de canal (o conjunto de equipamentos físicos colocados a disposição). A codificação da mensagem depende do tipo de mediunidade envolvida. Se for de efeitos físicos, a codificação obedece a simbologias convencionadas, a sistemas tiptográficos etc. Nas mediunidades já desenvolvidas de efeitos inteligentes, a codificação da mensagem se dá por mecanismos desconhecidos entre as mentes do médium e do Espírito comunicante.

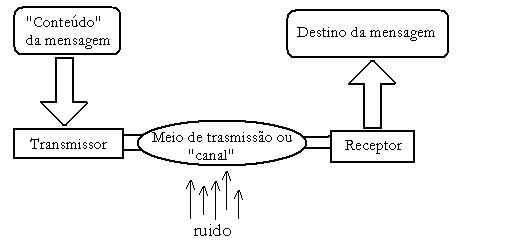

A Fig. 2 mostra exatamente como inserir ruído no modelo. Ruído é qualquer perturbação no processo de comunicação ou transporte de informação que leva a degradação do conteúdo da mensagem. O ruído atinge o canal de transmissão. Também as comunicações mediúnicas sofrem com ação do ruído (proveniente da própria mente do médium ou da ação de outros Espíritos) que obliteram o conteúdo da mensagem. Em sistemas artificiais (p. ex. comunicação celular), o ruído pode tornar o processo de comunicação inviável. Nesses casos pode-se falar em eficiência de transmissão de informação como função da razão entre a intensidade do ruído e a intensidade do sinal transmitido, a famosa relação sinal-ruído.

2. Uma definição simples de informação

Todos nós temos noção primitiva de informação. Quando alguém nos faz uma pergunta que só requer um "sim" ou "não" estamos dispostos a passar um conteúdo informativo em relação à resposta equivalente a uma unidade primitiva de informação (conhecida como "bit"). Nessa forma muito simples, informação é um conceito passível de quantificação. Se desejamos saber se a luz do quarto está acesa ou não então são necessários apenas 1 bit para se adquirir a informação necessária. Semelhantemente, questões mais complexas requerem quantidades maiores de informação. Importa-nos aqui lembrar que a "informação" é algo invisível, não palpável, que se pode transportar de um lugar para outro independentemente do meio material (ou de qualquer meio imaginável). O reconhecimento do "status" independente da informação veio apenas recentemente. Informação é algo que se transfere de um lugar para o outro, que se armazena (logo ocupa volume), que se mede embora sempre relativamente. Podemos apenas falar em ganho ou perda de informação, nunca em um valor absoluto para o conhecimento informativo de acordo com essa definição primitiva.

As modernas teorias sobre processamento de informação (sinais) quantificam-na de tal forma que podemos falar de "pacotes" de informação. Assim para o conjunto de 256 possibilidades de informação é utilizado a designação "bytes". Para quantidades maiores de informação adiciona-se os prefixos latinos de quantificação Kilo, Mega, Giga, etc para designiar respectivamente 1000, 1.000.000, 1.000.000.000 etc bytes de informação. Por que o número 256? Para isso é necessário considerar que a maior parte da quantificação da informação é feita por meio de uma base que requer sua representação na forma de respostas simples como "sim" e "não". Como só existem 2 respostas possíveis, o número 256 vem do número de possibilidades de resposta quando coexistem 8 "canais" de informação possíveis. Por exemplo, suponha que queiramos armazenar a quantidade necessária de informação necessária para saber que a luz da sala de uma casa está acesa e que a porta principal esta fechada. Nesse caso temos 4 possibilidades conforme mostra a sequência abaixo:

1) A luz da sala está acesa e a porta está aberta;

2) A luz da sala está acesa e a porta está fechada;

3) A luz da sala está apagada e a porta está aberta;

4) A luz da sala está apagada e a porta está fechada.

Essas possibilidades são armazenas na forma de 2 bits pois podemos considerar cada uma das afirmação acima como tendo valor "falso" ou "verdadeiro" ("sim" ou "não"). Ora 4 é o resultado de se elevar 2 ao número de "perguntas" existentes (ou número de bits). Se fizessemos mais uma pergunta, por exemplo, se o cachorro na casa foi alimentado às 8 horas da manhã, teríamos 3 perguntas e, daí, o conteúdo de informação necessário para responter satisfatóriamente as 3 inquirições (3 bits) seria 3. Da mesma forma um gabarito do tipo "falso"/"verdadeiro" com 8 perguntas exige que tenhamos disponíveis 2^8 possibilidades = 256 ou 1 byte como afirmado acima, e equivalente portanto a 8 bits de informação. Bits e bytes tornaram-se unidades importantes na definição e tratamento de informação por sistemas digitais justamente porque computadores só trabalham fundamentalmente com a base falso/verdadeiro em suas estruturas internas. Note que a quantidade de informação diz respeito ao número de bits necessário para armazenar todas as possibilidades uma vez que as sentenças no caso acima tem respostas não dependentes. Se a resposta de uma já definisse a solução de outra, então o conteúdo seria obviamente menor.

Essas noções primitivas de informação (totalmente dependentes do tipo de sinal utilizado para armazená-la) foram formalizadas por Claude Shannon em 1940 através de um formalismo conhecido como "Teoria da Informação" (também chamada "Teoria clássica da Informação") [2]. O nome “informação” aqui está mal empregado pois a teoria de Shannon é, de fato, uma teoria sobre sinais uma vez que o conteúdo informativo da “informação de Shannon” não é importante. O objetivo principal da teoria da informação era fornecer subsídios teóricos para o desenvolvimento de uma teoria geral de comunicações frente a agentes externos de atenuação de sinal e ruído. Essa teoria finalmente acabou constituindo-se no arcabouço fundamental dos modernos sistemas digitais e de comunicação "wireless" ou com fio (telefonia celular, redes de computadores etc). A informação definida segunda a equação (por Shannon) onde log² é o logaritmo na base 2 e N é o número de possíveis resultados ou símbolos. É um conceito puramente quantitativo que se presta mais a determinação da quantidade de espaço de memória necessário para se armazenar um determinada quantidade de dados. No caso do questionário com 8 questões, existem 256 possibilidades (N=256), logo I=8 bits.

Para o cômputo dessa quantidade de memória, é irrelevante o tipo de informação, muito menos ainda a qualidade da mesma. Dada duas sentenças:

1) AXGKP TOFFZAXXTAB OPPQ

2)BEATI PAUPERES SPIRITUS

Qual delas tem um significado mais familiar? Certamente a segunda que é a versão latina de "Bem aventurado os pobres de espírito". Para o conceito de quantidade de informação de Shannon, as duas sentenças tem o mesmo status, pois correspondem a mesma quantidade de informação. Assim não existe conexão alguma entre esse conceito de informação e a qualidade da mesma entendida como conhecimento. Mas a definição de Shannon é útil pois correponde ao que poderíamos chamar de primeira camada ou nível de descrição da informação (nível estatístico). Nesse nível, não existe sintaxe nem semântica. Fala-se apenas na probabilidade de uma determinada letra do alfabeto ou símbolo aparecer. Para simplificar, consideremos o alfabeto formado pelas seguintes letras:

a b c d e f g h i j k l m n o p q r s t u v x y w z " "

Onde " " representa o espaço em branco. Em uma primeira análise, se quisermos enviar uma mensagem escrita em um idioma que use esses símbolos, podemos falar que há probabilidade 1/26 de que a primeira letra da mensagem seja qualquer uma daquelas acima relacionadas. Dessa forma precisamos de

para enviar uma mensagem com esse alfabeto. Isso é, para cada letra. Para uma palavra com 5 letras seria necessário 5 x 4.7 = 23.5 bits de informação e assim sucessivamente. Note que não interessa para essa idéia quantitativa de "informação" se a mensagem formada pela seqüência de 5 símbolos representa a palavra "logos" ou "xksiw", o conteúdo informativo nos dois casos é o mesmo. O que diferencia um idioma de outro (além do grupo de símbolos que representa a mensagem) é algo imaterial, que não se pode quantificar através da informação de Shannon. O máximo de diferenciação mensurável por I está embutido na distribuição de probabilidades de ocorrência desses símbolos. (mas os idiomas se diferenciam antes pelos símbolos que usam). Por exemplo, na lingua inglesa a probabilidade de a letra "h" suceder a letra "t" é muito grande, pois há várias palavras com o sequência "th" (como no artigo "the" ou em "thanks") . Do mesmo modo, no português, a probabilidade de a letra "a" suceder "ç" é grande e, nessa ocorrência, é grande também a chance de aparecer a letra "o" (como em "ação"). Assim o cálculo exato da quantidade de informação para suprir uma definciência de memória no armazenamento de uma mensagem não é simples de se fazer.

As probabilidades funcionam como pesos estatísticos e cada idioma tem sua distribuição própria. Na ocorrência de dois idiomas que utilizem o mesmo conjunto de símbolos, é possível reconhecer o idioma simplesmente calculando-se a distribuição de ocorrência de letras, mas isso é tudo que podemos extrair do conceito de informação de Shannon que é largamente utilizado nas ciências da computação.

3. Examinando de perto o processo de transmissão de informação. Computadores como manipuladores de sinais

A transmissão de informação de um sistema a outro (utilizando o conceito de Shannon) pode ser descrita de maneira muito simples, e é relevante para o que discutiremos posteriormente. Nosso objetivo é compreender claramente a informação genuína como um dos atributos de um sistema inteligente; algo que é por ele gerado e manipulado, embora o conceito de informação que utilizamos aqui não leve em consideração o conteúdo da mensagem. Veremos que onde há informação há inteligência, embora seja possível criar sistema aparentemente inteligentes pelo fato de poderem manipular informação.

Consideremos inicialmente dois sistemas idênticos. O que os diferencia além de suas características próprias? Usemos o exemplo anterior, a casa com a sala e a porta. Duas casas idênticas com a mesma sala e porta diferem entretanto pelo estado em que se encontra a lâmpada da sala (se acesa ou apagada) e a porta (se aberta ou fechada). Nessas duas casas idênticas aquela em que conhecemos o estado da lâmpada e da porta é a casa com maior conteúdo de informação simplesmente porque, para descrever qualquer outro aspecto da casa, precisamos de menos informação com essa casa do que com a outra sobre a qual nada sabemos. De outra forma, podemos também dizer que no caso da primeira casa (que sabemos a luz estar acesa e a porta fechada) nossa ignorância é menor do que no caso da segunda casa. Note-se que o conteúdo da informação está contido na sequência de perguntas e suas respectivas respostas.

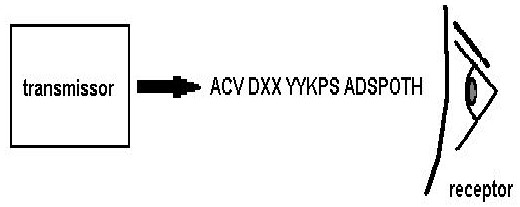

Examinemos agora detalhadamente o processo de comunicação. A figura abaixo representa uma versão simplificada de um processo desse tipo com os componentes da fig. 1.

Uma mensagem (constituída por uma seqüência de símbolos) é enviada pelo transmissor para o receptor. Não importa aqui qual o tipo de processo (se eletrônico, sonoro, luminoso, mediúnico etc). Toda vez que um símbolo é percebido pelo receptor seu conteúdo de informação "aumenta" exatamente de I (usando o alfabeto anterior como exemplo, esse ganho de informação é de aproximadamente 4.7 bits para cada símbolo). Uma outra medida é utilizada pela teoria da informação para quantificar o conteúdo informativo de uma mensagem. Essa medida é conhecida como Entropia e é definida simplesmente como a média ponderada pelos pesos estatísticos da quantidade de informacão:

Entropia de informação = <I>= - ( p1*log2 p1+p2*log2 p2+...+pN log2 pN )

onde p1, p2, .. , pN são os pesos de cada símbolo. A entropia de informação definida dessa forma é uma quantidade que cresce com o número de símbolos usados para codificar a mensagem. Cresce também com o tamanho da mensagem e, como no caso da informação de Shannon, não serve para mensurar o conteúdo sintático de uma mensagem, muito menos seu conteúdo tal como os seres humanos internamente o compreendem.

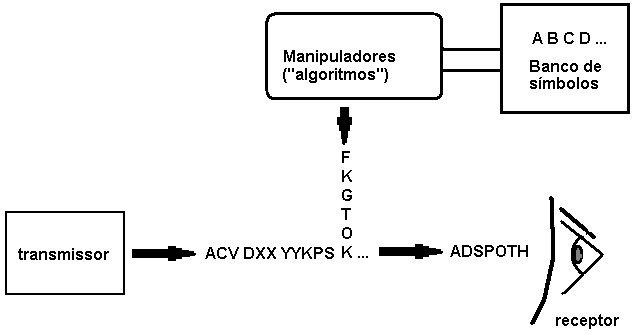

No processo de comunicação descrito pela Fig. 3, não explicitamos a origem da informação. Consideremos inicialmente que essa origem seja “inteligente”. Imaginemos que o processo seja interceptado por um sistema mecânico (autômata) que possa acrescentar ou modificar a seqüência de símbolos original. A fig. 4 ilustra o processo modificado por esse agente externo.

O autômata é capaz de acrescentar símbolos à seqüência original de forma independente. Isso ele faz recorrendo a um banco de símbolos que permite a reprodução infinita de qualquer tipo de símbolo pertencente ao alfabeto convencionado pelo processo de comunicação. Além disso para uma dada seqüência de símbolos, a ordem ou disposição pode ser artificialemente modificada por uma seqüência de comandos lógicos chamados “algoritmos”. Não importa para nós aqui a origem dos algoritmos (embora sabemos que sua construção obedece a regras dos seres humanos). Chamamos a atenção com o processo modificado de comunicação da Fig. 3 que o autômata pode aumentar arbitrariamente o conteúdo informativo da mensagem original somente no sentido da teoria da informação de Shannon que não leva em consideração o significado da mesma para o destino último da mensagem. Afirmamos explicitamente: não importa a complexidade, grau de manipulação dos “algoritmos” previamente programados no autômata, qualquer que seja a natureza e resultado do conjunto de instruções o conteúdo verdadeiramente informativo da mensagem original não é aumentado. Isso vale para qualquer tipo de autômata. De fato, podemos representar o conjunto de operações sobre cada bit original como a aplicação de uma função genérica G(u) onde u é bit de entrada: Para a sequência original: u1, u2, u3 de símbolos pertencentes ao alfabeto, o resultado final é G(u1), G(u2), G(u3), ...até o último bit enviado. Em particular o processo de “comunicação” do receptor final com o autômata pode ser descrito para uma seqüência de entradas nulas. Assim sendo, não existe comunicação no sentido genuíno de troca de informação do autômato para com o receptor final suposto inteligente (embora esse último possa ter a impressão de que isso ocorra de fato).

Longe de gerar informação, computadores são sistemas que apenas conseguem manipular ou gerar sinais baseados em algoritmos. Todo o conteúdo aparentemente inteligente (cognitivo) das mensagens ou da manipulação de informação por computadores advém da inteligência (Espírito) dos seres humanos que os programaram.

4. Informação e o princípio inteligente

Nosso principal problema é a inexistência de uma definição suficientemente abrangente para a idéia de informação. Podemos entretanto definir alguns de seus atributos. Para isso baseamo-nos em considerações do matemático Wernher Gitt [3]. Ele descreve esses atributos do processo de transmissão de informação em cinco camadas:

2- Sintaxe: referente ao seqüenciamento dos símbolos formando palavras e frases. Dependendo da ordem com que são transmitidos, um conjunto de símbolos podem formar palavras diferentes. Como vimos nem essa seqüência é importante na teoria dos sinais de Shannon;

3- Semântica: que diz respeito ao significado das palavras. Pelo fato de o nível semântico ser de caracterização quantitativa inexistente, o preço dos telegramas só depende da quantidade de símbolos (palavras) que ele porta e não de seu conteúdo;

4- Pragmática: que diz respeito à intenção do transmissor com o conteúdo informativo da mensagem e seu impacto no receptor. A fim de que o receptor tenha determinada reação, o transmissor reveste sua informação de conteúdo pragmático

Que Kardec utilizou essas propriedades na caracterização das mensagens mediúnicas não resta dúvida. Examinemos, por exemplo, o parágrafo 66 de “O Livro dos Médiums” no Capítulo III, “Das manifestações inteligentes”:

“Para uma manifestação ser inteligente, indispensável não é que seja eloqüente, espirituosa, ou sábia, basta que prove ser de um ato livre e voluntário, exprimindo uma intenção, ou respondendo a um pensamento. Decerto, quando uma ventoinha se move, toda gente sabe que apenas obedece a uma impulsão mecânica: à do vento; mas, se se reconhecem nos seus movimentos sinais de serem eles intencionais, se ela girasse para a direita ou para a esquerda, depressa ou devagar, conforme se lhe ordenasse, forçoso seria admitir-se, não que a ventoinha era inteligente, porém, que obedecia a uma inteligência. Isso o que se deu com a mesa.”

Muito além de seu tempo, Kardec soube caracterizar as propriedades superiores das mensagens de conteúdo informativo inteligente que hoje é largamente utilizada na pesquisa por sinais inteligentes vindos do espaço ou na análise do processo de comunicação dos animais. De acordo com esses cinco níveis (que levam em conta a intenção do comunicante), podemos excluir a grande classe de sistemas naturais mecânicos (físicos) como geradores de informação. É o que Kardec diz quando utiliza do exemplo da ventoinha. No máximo tais sistemas gerariam sinais no nível estatístico sem significado. Por outro lado, a Natureza está cheia de criaturas capazes de se comunicar nos cinco níveis descritos acima. Sabemos que os animais se comunicam (consideremos as linguagens químicas das formigas ou o canto das baleias), logo trocam informação. O processo de comunicação nesses seres se dá muito de acordo com o modelo da Fig. 1 e nos cinco níveis descrito, onde podemos identificar cada um dos elementos da cadeia comunicativa. Machos de várias espécies de pássaros cantam para as fêmeas para chamar a atenção ou para reinvidicar território (um exemplo de comunicação até o nível pragmático). Mesmo com as plantas - embora muito limitadamente - há comunicação (consideremos os fenômenos de polinização com o esforço das flores em se tornarem atraentes aos insetos). Visto pura e simplesmente do ponto de vista do que temos discutido aqui, os seres humanos (Espíritos encarnados) podem ser vistos como seres vivos capazes de transformar energia química em informação. Essa definição é amplamente aceita na comunidade acadêmica (embora haja divergências quanto ao significado do termo informação) pois corresponde exatamente aos fatos. O problema aqui é saber onde está a origem da informação. Como vimos, depois de eliminar os sistemas mecânicos (o que inclui sistemas químicos ou bioquímicos reduzidos aos seus componentes atômicos), o que nos sobra?

Informação como fonte no princípio inteligente: somente o espírito, tendo como atributo o princípio inteligente, é capaz de gerar, armazenar e manipular a informação que só pode ser compreendida cognitivamente por outra entidade que disponha desse mesmo atributo.

Em outros termos propomos que a origem de toda informação, tal como descrita em seus atributos pelos níveis estatístico, sintático, semântico e abobético, está no espírito. Obvimente por “linguagem” não nos restringimos exclusivamente às representações gráficas e fonéticas de símbolos que nós, Espíritos encarnados em evolução, inventamos para facilitar o processo de comunicação. Seres considerados inferiores, mas que dispõem de princípio inteligente, comunicam-se por linguagem que podemos considerar primitiva (códigos químicos ou bioquímicos), o que propomos como uma evidência de sua natureza espiritual. A Natureza bruta não gera informação. Como Kardec na sua análise das manifestações inteligentes, hoje podemos dizer que forçoso é admitir-se, não que a matéria nesses casos seja inteligente, mas que obedeçe a uma inteligência. Essa inteligência é um atributo do Espírito.

5. Algumas considerações

Exobiologia

Há um debate recente sobre a possibilidade de se descobrir vida inteligente em outros planetas para além de nosso sistema solar. Sabemos que a Doutrina Espírita previou com grande antecedência essa possibilidade. Atualmente, um programa de pesquisa bastante audacioso [4] está em andamento visando detectar vida extraterrestre totalmente baseados em sinais de rádio. A parte do problema de escolha de canal de transmissão, para que sejam aceitos como prova da existência dessas civilizações, esses sinais devem satisfazer um conjunto de critérios que passam pela análise da verificação dos atributos descritos na parte 4. A grande maioria dos sinais detectados via rádio obedecem padrões meramente estatísticos, isto é, não se caracterizam como sinais inteligentes pois são geradas por fontes naturais (estrelas, nuvens interestelares etc). Para que o sejam devem ter um objetivo contido na própria mensagem. Reconhe-se assim o caráter não físico das mensagem genuinamente inteligentes.

Biologia

A biologia moderna descobriu que a chave para a estrutura dos seres vivos está no código genético. O DNA ou RNA são longas cadeias moledulares que descreveriam bioquimicamente os constituintes últimos dos seres vivos. O código genético é uma molécula com conteúdo altamente informativo (do ponto de vista da informação de Shannon, o DNA humano contém mais informação que todos os livros já editados na Terra). Um debate recente tem acontecido na comunidade acadêmica sobre a origem dessa cadeia. Já se calculou corretamente que a probabilidade de os átomos do DNA humano apresentarem seu arranjo característico por mera chance ser ínfimo. Isso deu origem a clamores recentes por parte dos neocriacionistas [3] de que a estrutura do DNA ter sido “dada por Deus”. Os opositores, baseados em modelos computacionais, puderam mostrar que essa sequência poderia ter sido gerada por chance se esta fosse assitida por algum mecanismo externo. De uma maneira muito simplificada imagina-se que a Natureza tenha uma função resposta que resulta em pesos altos caso a chance vá na direção correta (embora não se especifique quem seja o responsável por especificar qual seja essa direção). De maneira geral acredita-se que mecanismos de evolução das espécies, mutações e seleção natural tenham sido os responsáveis ao longo do tempo pela forma final da molécula.

De nossa parte acreditamos que o argumento de “dada por Deus” é naturalmente válido pois Deus é a causa primária de todas as coisas. Porém podemos imaginar que o DNA represente hoje uma espécie de “documento material” que ateste o processo de evolução conjunta (através dos milhares de anos) do princípio espiritual com a matéria. Assim a origem do conteúdo informativo da molécula DNA e de outras proteínas importantes no metabolismos dos seres seria o próprio princípio espiritual em sua viagem de evolução ao longo de múltiplos renascimentos na matéria. Essa proposição parece ser atestada por muitos autores espirituais [5].

A física desbancada?

O reconhecimento da importância da informação no Universo (assim como a matéria e a energia) e sua origem no princípio inteligente é um profundo golpe no reducionismo que previa ser possível reduzir todo nosso conhecimento das ciências às interações físicas entre seus constituintes. Mostra também que a descrição da “matéria viva” não pode ser feita baseando-se exclusivamente em princípios mecânicos ou quanto-mecânicos. Sistemas auto-organizáveis [6] têm sido propostos como modelos para a matéria viva, entretanto, à luz do que estamos expondo, esses sistemas são meros geradores de ordem (diminuição da entropia por serem sistemas abertos longe do equilíbrio) e não de informação. Essa conclusão pode ser revista no futuro pois o problema da origem da informação só muito recentemente recebeu atenção devida e não faz parte do programa normal de pesquisa da física.

6. Nota conclusiva

Isso posto concluímos que o princípio utilizado pelo codificador da Doutrina Espírita, Allan Kardec, que viu uma causa inteligente nas mensagens inteligentes [1] e com isso descobriu a origem não material das inteligências por detrás das mensagens pode ser expandido para toda a Natureza. Ousamos dizer que se a origem das comunicações mediúnicas foi atestadamente demonstrada como tendo origem em inteligências incorpóreas, então, muito provavelmente, a origem de toda informação com conteúdo verdadeiramente cognitivo não pode ser atribuída à matéria. Isso se extende a todos os fenômenos existentes que podemos classificar como tendo um objetivo ou inteligência.

Referências

[1] O Livro dos Médiums, Parágrafo 65, Capítulo III, Das manifestações inteligentes. 54ª Edição da Federação Espírita Brasileira, Tradução de Guillon Ribeiro. Ver também Ref. [7] “Prolegômenos”.

[2] C. E. Shannon, ``A mathematical theory of communication,'' Bell System Technical Journal, 27, pp. 379-423 and 623-656,. Julho e Outubro de 1948.

[3] Werner Gitt “Information, science and biology”. Publicado em Technical Journal 10 (2): 181-187. Agosto de 1996.

[4] Ver www.seti.org (SETI - “Search for Extraterrestrial Inteligence”). “The mission of the SETI Institute is to explore, understand and explain the origin, nature and prevalence of life in the universe.” A missão do intituto SETI é explorar, compreender e explicar a origem, naturesa e prevalência de vida no Universo.

[5] André Luiz, Evolução em Dois Mundos, Cap. VII, “Evolução da Hereditariedade”, 4ª edição. Federação Espírita Brasileira (1977).

[6] Ver Press Release: The 1977 Nobel Prize of Chemistry (nobelprize.org). Nota para a imprensa sobre o prêmio Nobel de 1977 concedido a Ilya Prigogine por suas colaborações em termodinâmica fora do equilíbrio e estruturas dissipativas.

[7] A Kardec, O Livro dos Espíritos, Tradução de Guillon Ribeiro, 71ª edição. Federação Espírita Brasileira (1991).

Fonte: Boletim GEAE 13(485), 23/11/2004